精通

英语

和

开源

,

擅长

开发

与

培训

,

胸怀四海

第一信赖

锐英源精品开源心得,禁止全文或局部转载,禁止任何形式的非法使用,侵权必究

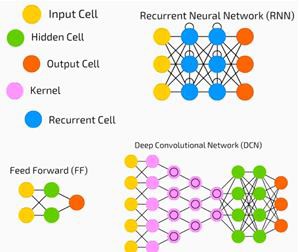

人类大脑由大量的神经细胞组成,神经细胞间通过生物电通信,生物电的传递分发汇聚就会有一个逻辑思维结果。根据这种形式,数学家和计算机专家设计了计算机神经网络平台,对平台先训练,随后让平台针对数据执行逻辑,获取逻辑结果。

深度神经网络(DNN)是在输入和输出层之间具有多个隐藏层的ANN。与浅层ANN相似,DNN可以对复杂的非线性关系建模。

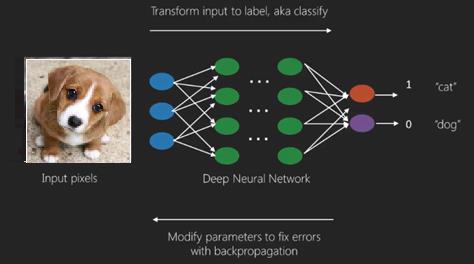

神经网络的主要目的是接收一组输入,对它们进行渐进的复杂计算,并提供输出以解决诸如分类之类的现实问题。我们限制自己前馈神经网络。

在深度网络中,我们具有输入、输出和顺序数据流。

神经网络广泛用于监督学习和强化学习问题。这些网络基于彼此连接的一组层。

在深度学习中,隐藏层的数量(大部分是非线性的)可能很大;说大约1000层。

DL模型比普通的ML网络产生更好的结果。

我们主要使用梯度下降法来优化网络并最小化损失函数。

我们可以使用Imagenet(数百万个数字图像的存储库)将数据集分类为猫和狗等类别。DL网络越来越多地用于除静态图像之外的动态图像以及时间序列和文本分析。

训练数据集是深度学习模型的重要组成部分。另外,反向传播是训练DL模型的主要算法。

DL处理具有复杂输入输出转换的大型神经网络的训练。

DL的一个示例是将照片映射到照片中的人的名字,就像他们在社交网络上所做的那样,并用短语描述照片是DL的另一项最新应用。

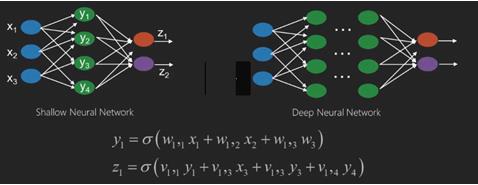

注意这里的符号比较有意思,括号前的圆形加右帽表示汇总括号内项,而W和V则表示逻辑因子和网络节点结合。

神经网络是具有x1,x2,x3等输入的函数,这些函数在两个(浅网络)或几个中间操作(也称为层)(深层网络)中转换为z1,z2,z3等输出。

权重和偏差会随层的不同而变化。“ w”和“ v”是神经网络各层的权重或突触。

深度学习的最佳用例是有监督的学习问题。在这里,我们有大量的数据输入和所需的一组输出。

图形的意思是像素点是蓝色圆形,是输入,经过绿点神经网络节点的分析,生成了是否小狗的结果。

在这里,我们应用反向传播算法来获得正确的输出预测。

深度学习的最基本数据集是MNIST,这是手写数字的数据集。

我们可以使用Keras训练深层的卷积神经网络,以对该数据集中的手写数字图像进行分类。

触发或激活神经网络分类器会产生一个分数。例如,为了将患者分类为疾病和健康患者,我们考虑诸如身高,体重和体温,血压等参数。

高分表示患者生病,低分表示患者健康。

输出层和隐藏层中的每个节点都有自己的分类器。输入层接受输入并将其分数传递到下一个隐藏层以进行进一步激活,并一直进行到达到输出为止。

从输入到输出从左到右沿向前方向的这种进展称为前向传播。

神经网络中的信用分配路径(CAP)是从输入到输出的一系列转换。CAP详细说明了输入和输出之间可能的因果关系。

给定前馈神经网络的CAP深度或CAP深度是隐藏层的数量加上包含输出层的一层。对于递归神经网络,其中信号可能会多次传播穿过一层,因此CAP深度可能是无限的。

DNN是复杂的算法平台,对于理论有所了解后,一般是要找些例子跑起来,通过输入、日志、变量情况和输出来彻底掌握,这里对DNN开源项目调研情况进行说明:。

首先是算法上优化,科大讯飞将整个DNN环节进行优化压缩,取缔了MFCC、HLDA、VTLN、FMPE等环节,只保留Filter Bank、FFT、Wave、Seq.Train、FMPE等流程,整个架构循环由优化了40%,大幅度的增加了运算速度与效率。

在DNN-HMMs模型中,P(x∣s) P(x|s)P(x∣s)是用DNN来建模。

用DNN学习出分类模型P(s∣x) P(s|x)P(s∣x),而后通过P(s∣x)P(s) \frac{P(s|x)}{P(s)}

P(s)

P(s∣x)

转为HMMs需要的输出概率分布(替换掉GMMs),结合HMMs构建出完整的语音识别模型

Facebook的wav2letter暂时只支持英语

DNN-HMMs模型的整体训练和识别流程可以概括为:最优状态序列-》N状态分数-》HMM转移概率参数-》重新

pytorch-kaldi好像也很正规,下个版本可以,本版本不太好。

MiniDNN是头文件开源库,可以学些DNN的层分析过程。

A Note on Neural Networks – CodeProject,js实现的简单模拟

CubbyDNN ,C++库

GlottDNN Vocoder好像是做语音转换或增强。

FasterRCNN_SpringEdition,C++版本,比较全,但是比较占内存

https://github.com/vysotin/dnn_speech_recognition,里面提到了语言模型。